type

status

date

slug

summary

tags

category

icon

password

在VMware虚拟机集群上部署HDFS集群

前置准备

- 由于 Hadoop 集群的特殊性,我们需要先准备三台虚拟机作为集群,硬件配置如下:

节点 | CPU | 内存 |

node1 | 1核心 | 4GB |

node2 | 2核心 | 2GB |

node3 | 3核心 | 2GB |

- Hadoop HDFS 的角色包括:

- NameNode 主节点管理者

- DataNode 从节点工作者

- SecondaryNameNode 主节点辅助

- 服务分配如下:

节点 | 服务 |

node1 | NameNode、DataNode、SecondaryNameNode |

node2 | DataNode |

node3 | DataNode |

上传 & 解压

- 上传 Hadoop 安装包到 node1 节点中

- 解压缩安装包到

/export/server路径下

- 构建软连接

- 进入 hadoop 安装包内

修改配置文件,应用自定义配置

- 配置 workers 文件

填入的 node1、node2、node3 表明集群记录了三个从节点(DataNode)

- 配置 hadoop-env.sh 文件

通过记录这些环境变量, 来指明上述运行时的重要信息

- 配置 core-site.xml 文件

hdfs://node1:8020 为整个 HDFS 内部的通讯地址,应用协议为 hdfs://(Hadoop内置协议)表明 DataNode 将和 node1 的 8020 端口通讯,node1 是 NameNode 所在机器此配置固定了 node1 必须启动 NameNode 进程

- 配置 hdfs-site.xml 文件

准备数据目录

根据下叙 2 个配置项

在 node1 节点:

在 node2 和 node3 节点:

分发 Hadoop 文件夹

已经基本完成 Hadoop 的配置操作,可以从 node1 将 hadoop 安装文件夹远程复制到 node2、node3

- 分发

- 在 node2 执行,为 hadoop 配置软链接

- 在 node3 执行,为 hadoop 配置软链接

配置环境变量

为了方便我们操作 Hadoop,可以将 Hadoop 的一些脚本、程序配置到 PATH 中,方便后续使用

在 Hadoop 文件夹中的 bin、sbin 两个文件夹内有许多的脚本和程序,现在来配置一下环境变量

- vim /etc/profile

- 在 node2 和 node3 配置同样的环境变量

授权为 hadoop 用户

hadoop 部署的准备工作基本完成

为了确保安全,hadoop 系统不以 root 用户启动,我们以普通用户 hadoop 来启动整个 Hadoop 服务

所以,现在需要对文件权限进行授权

此处确保已经提前创建好了 hadoop 用户(具体实现在前置准备章节中),并配置好了 hadoop 用户之间的免密登录

操作如下:

以 root 身份,在 node1、node2、node3 三台服务器上均执行如下命令

格式化整个文件系统

前期准备全部完成,现在对整个文件系统执行初始化

- 格式化 namenode

- 启动

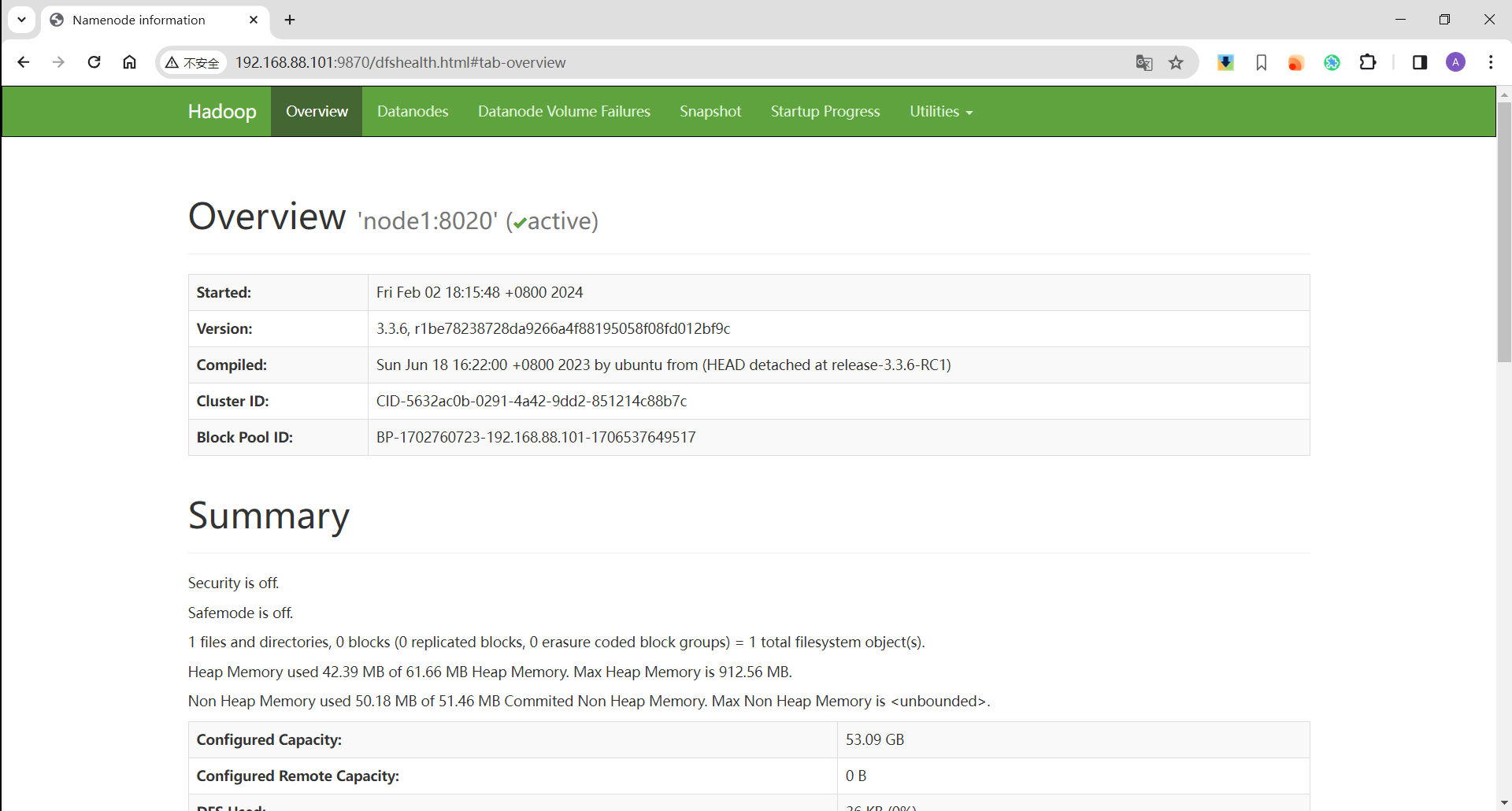

查看 HDFS WEBUI

启动完成后,可以在浏览器打开:

http://node1:9870,即可查看到hdfs文件系统的管理网页

如果有打不开的情况,可以直接使用 node1 的 ip 地址进行访问

- 作者:Tuwilt

- 链接:https:/blog.tuwilt.top/article/ff053c51-b3fd-4966-949c-0d293bbf4fc2

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。